챗GPT 가고 GPT-4V가 온다 존맛탱 번역하고 엑스레이 영상도 분석

챗GPT 가고 GPT-4V가 온다 존맛탱 번역하고 엑스레이 영상도 분석

올해의 단어를 꼽으라면 ‘LLM(대규모언어모델)’을 빼놓고 이야기하기는 힘들 것 같다.

작년 말 오픈AI의 챗GPT가 공개된 이후 LLM은 정보기술(IT) 분야를 넘어서 일상 곳곳에 자리잡았다.

그런데 불과 1년 만에 LLM이라는 단어도 낡은 유산으로 전락할 처지다.

LLM을 대신할 새로운 용어가 인공지능(AI) 업계에 등장했기 때문이다.

바로 ‘LMM(대규모멀티모달모델)’이 챗GPT 등장 1년 만에 AI 업계의 판도를 바꿀 새로운 ‘게임 체인저’로 주목받고 있다.

LLM와 LMM의 차이는 언어와 멀티모달에 있다.

LLM이 대규모로 언어 모델을 학습했다면 LMM은 멀티모달을 학습했다고 보면 된다.

멀티모달은 텍스트 외에 이미지와 음성 같은 다양한 방식을 사용하는 AI를 말한다.

챗GPT가 텍스트에 기반해서 이용자와 질문과 대답을 주고 받는 AI였다면

LMM을 적용한 AI는 텍스트뿐만 아니라 이미지와 음성까지도 이용할 수 있게 되는 셈이다.

LMM은 많은 AI전문가들이 챗GPT의 다음으로 주목했던 기술이다.

하지만 이미지와 음성을 인식하고 출력하는 기술은 텍스트를 대상으로 하는 것과는 비교가 안 되게 어려움이 클 것이라는 예상이 많았다.

LMM의 시대가 오기까지는 제법 시간이 걸릴 것이라는 전망이 많았다.

그런데 오픈AI가 다시 한 번 그 예상을 깼다.

오픈AI가 지난 9월 25일 공개한 ‘GPT-4V(ision)’는 AI 전문가들을 깜짝 놀라게 했다.

GPT-4V는 이용자가 이미지를 올리고 이미지에 대한 질문을 할 수 있는 LMM으로, 사실상 전 세계에서 처음으로 대중화된 LMM 서비스다.

오픈AI는 이미 작년 말 GPT-4V를 위한 학습을 마치고, 올해에는 알파 그룹의 사용자에게 접근 권한을 부여한 뒤 테스트를 진행해 GPT-4V의 신뢰도를 높였다.

공개 직전인 9월 초에는 베타테스터 규모를 1만6000명까지 늘리기도 했다.

이렇게 출시된 GPT-4V는 챗GPT와는 또다른 충격을 주고 있다.

많은 사람들이 GPT-4V가 어떤 이미지까지 인식할 수 있는지 실험에 나서고 있는데,

챗GPT가 처음 나왔을 때 챗GPT에 질문을 던지는 게 일종의 ‘밈’처럼 이뤄진 것과 같은 분위기다.

지난 9월 29일에는 마이크로소프트의 연구자들이 GPT-4V를 이용해 다양한 실험을 진행한 논문이 공개되기도 했다.

단순한 이미지 해석에서부터 스도쿠 같은 게임을 이용한 추리, 인물의 표정을 통해 기분을 유추하는 것 등 다양한 실험이 망라돼 있었다.

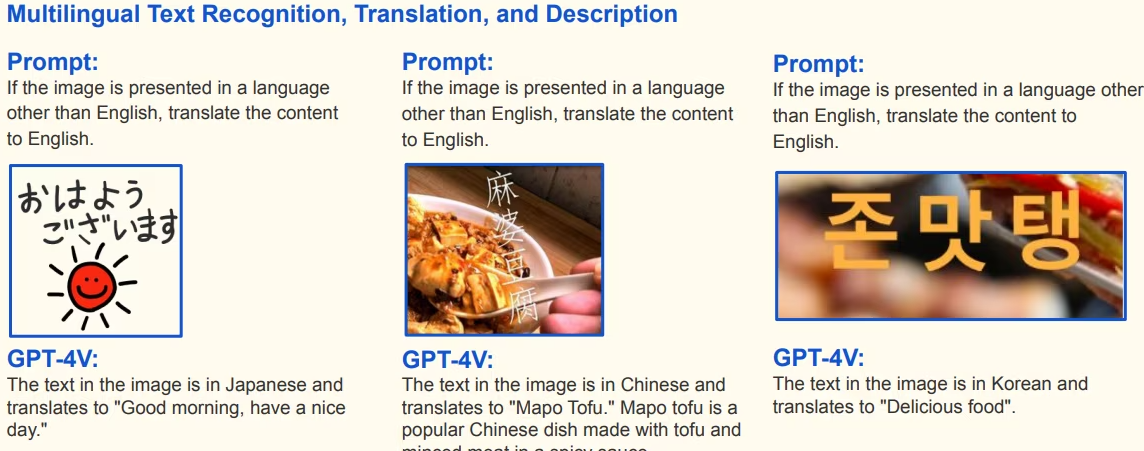

특히 인상깊은 건 엑스레이 이미지를 보고 골절 부위를 지목한다거나 영어가 아닌 다른 국가의 언어가 들어간 이미지까지 제대로 해석해서 설명을 내놓는다는 점이었다.

김밥을 만드는 순서를 정확하게 나열하거나 손글씨로 제시된 이미지도 문제 없이 이해하는 모습이었다.